研究显示大型图像文本人工智能模型的偏见有利于更富裕的西方观点

在一项评估 OpenAI 的 CLIP(一种将文本和图像配对并在流行的 DALL-E 图像生成器的幕后运行的模型)偏差的研究中,密歇根大学的研究人员发现 CLIP 在描绘低收入和非收入群体的图像上表现不佳。西方的生活方式。

“当人工智能工具在世界范围内部署时,让每个人都参与到这些工具中至关重要。然而,我们发现很大一部分人口并没有被这些应用程序所反映——毫不奇怪,来自社会收入最低的人群“这可能很快导致更大的不平等差距,”该项目的发起者和顾问、贾尼斯·M·詹金斯学院计算机科学与工程教授 Rada Mihalcea 说。

像 CLIP 这样的人工智能模型可以作为基础模型或基于大量未标记数据进行训练的模型,可以适应许多应用程序。当人工智能模型使用反映片面世界观的数据进行训练时,这种偏见可能会传播到依赖人工智能的下游应用程序和工具中。

“如果软件使用 CLIP 来筛选图像,它可能会排除来自低收入或少数群体的图像,而不是真正贴错标签的图像。它可能会扫除数据库管理员努力包含的所有多样性,”计算机科学与工程博士生。

Nwatu 与同系博士后 Oana Ignat 共同领导了该研究团队。他们共同撰写了一篇论文,并于 12 月 8 日在新加坡举行的自然语言处理经验方法会议上发表。该论文还发布在arXiv预印本服务器上。

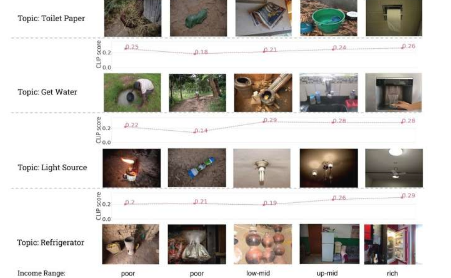

研究人员使用 Dollar Street(Gapminder 基金会创建的全球多样化图像数据集)评估了 CLIP 的性能。Dollar Street 包含从非洲、美洲、亚洲和欧洲不同收入的家庭收集的 38,000 多张图像。数据集中的月收入范围从 26 美元到近 20,000 美元不等。这些图像捕捉日常物品,并用一个或多个上下文主题手动注释,例如“厨房”或“床”。

CLIP 通过创建一个分数来配对文本和图像,该分数旨在表示图像和文本的匹配程度。然后可以将该分数输入下游应用程序以进行进一步处理,例如图像标记和标签。OpenAI 的 DALL-E 的性能在很大程度上依赖于 CLIP,CLIP 用于评估模型的性能并创建训练 DALL-E 的图像字幕数据库。

研究人员首先对 Dollar Street 数据集的图像与 CLIP 中手动注释文本之间的匹配度进行评分,然后测量 CLIP 评分与家庭收入之间的相关性,从而评估 CLIP 的偏差。

“我们发现,与低收入家庭的图像相比,大多数来自高收入家庭的图像总是具有更高的 CLIP 分数, ” Nwatu说。

例如,与贫困家庭的煤油灯相比,富裕家庭的电灯在“光源”主题上的 CLIP 分数通常更高。

CLIP 还表现出地域偏见,因为大多数得分最低的国家都来自低收入非洲国家。这种偏见可能会消除大型图像数据集的多样性,并导致低收入非西方家庭在依赖 CLIP 的应用程序中代表性不足。

“许多人工智能模型的目标是通过利用来自西方国家的英语数据来实现‘一般性理解’。然而,我们的研究表明,这种方法会导致不同人口统计数据之间存在相当大的性能差距,”伊格纳特说。

“这一差距很重要,因为人口因素塑造了我们的身份,并直接影响模型在现实世界中的有效性。忽视这些因素可能会加剧歧视和贫困。我们的研究旨在弥合这一差距,并为更具包容性和可靠的模型铺平道路。 ”

研究人员为人工智能开发人员提供了几个可行的步骤,以构建更公平的人工智能模型:

投资于地理上不同的数据集,以帮助人工智能工具了解更多样化的背景和观点。

通过考虑位置和收入来定义代表每个人的评估指标。

记录人工智能模型训练数据的人口统计数据。

纳瓦图说:“公众应该知道人工智能接受了哪些培训,以便他们在使用工具时能够做出明智的决定。”

免责声明:本答案或内容为用户上传,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。 如遇侵权请及时联系本站删除。