人机博弈历史悠久,一直是验证人工智能关键技术的主要工具。1950年提出的图灵测试是第一个判断机器是否具有人类智能的人机游戏。这激发了研究人员开发能够挑战职业人类玩家的人工智能系统(AI)。

一个典型的例子是名为 Chinook 的西洋跳棋 AI,它于 1989 年开发,用于击败世界冠军。1994年,它击败了Marion Tinsley,实现了这一目标。随后,IBM的“深蓝”在1997年击败了国际象棋大师加里·卡斯帕罗夫,开创了人机游戏历史的新纪元。

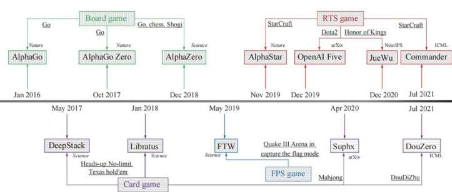

近年来,研究人员见证了人机游戏AI的快速发展,从DQN智能体、AlphaGo、Libratus、OpenAI Five到AlphaStar。这些人工智能结合现代技术,可以在某些游戏中击败职业人类玩家,这标志着决策智能迈出了一大步。

例如,AlphaGo Zero利用蒙特卡罗树搜索、自对弈和深度学习,击败了数十名职业围棋棋手,代表了大型状态完美信息博弈的强大技术。OpenAI Five 使用自我对弈、深度强化学习和通过手术进行持续迁移,成为第一个在电子竞技比赛中击败世界冠军的人工智能,展示了复杂不完美信息游戏的有用技术。

在 AlphaStar 和 OpenAI Five 分别在《星际争霸》和《Dota2》游戏中达到职业人类玩家水平的成功之后,目前的技术似乎可以解决非常复杂的游戏。尤其是《王者荣耀》、《麻将》等最新人机游戏AI的突破,都遵循AlphaStar和OpenAI Five的类似框架,表明现有技术具有一定的通用性。

因此,一个自然的问题出现了:当前人机游戏技术可能面临哪些挑战,未来的趋势是什么?《机器智能研究》上发表的一篇新论文旨在回顾最近成功的人机游戏人工智能,并试图通过对当前技术的彻底分析来回答这个问题。

基于目前人机游戏AI的突破(大多发表在《Science》、《Nature》等期刊上),研究人员调查了四种典型的游戏类型,即围棋棋盘游戏;单挑无限注德州扑克(HUNL)、斗地主、麻将等纸牌游戏;第一人称射击游戏(FPS),《Quake III Arena》中的夺旗游戏(CTF);即时战略游戏 (RTS),包括《星际争霸》、《Dota2》和《王者荣耀》。对应的AI包括AlphaGo、AlphaGo Zero、AlphaZero、Libratus、DeepStack、DouZero、Suphx、FTW、AlphaStar、OpenAI Five、JueWu和Commander。

在本文的其余部分安排如下。在第 2 部分中,研究人员描述了本文涵盖的游戏和人工智能。本文基于人机游戏人工智能的最新进展,综述了棋盘游戏、卡牌游戏、FPS游戏和RTS游戏四类游戏及其相应的人工智能。为了衡量游戏开发专业人类级人工智能的难度,研究人员提取了挑战智能决策的几个关键因素,即不完美信息、长时间范围、传递博弈和多智能体合作。

第 3 节是关于棋盘游戏 AI。AlphaGo系列是基于蒙特卡罗树搜索(MCTS)构建的,该算法在之前的围棋程序中广泛使用。AlphaGo于2015年问世,击败了欧洲围棋冠军樊麾,这是人工智能首次在没有伦子的全尺寸围棋比赛中战胜职业棋手。随后,利用不同的学习框架开发了名为AlphaGo Zero的高级版本,无需事先提供专业的人类对抗数据,即可达到超人的性能。AlphaZero 使用与 AlphaGo Zero 类似的学习框架,并探索通用的强化学习算法,该算法掌握了围棋以及另外两种棋盘游戏:国际象棋和将棋。

第 4 节介绍纸牌游戏 AI。卡牌游戏作为一种典型的非完美信息游戏,一直是人工智能面临的挑战。DeepStack 和 Libratus 是在 HUNL 中击败职业扑克玩家的两个典型 AI 系统。它们共享相同的基本技术,即反事实后悔最小化(CFR)。随后,研究人员开始关注麻将和斗地主,这对人工智能提出了新的挑战。Suphx由微软亚洲研究院开发,是第一个在麻将比赛中超越大多数顶级人类玩家的人工智能系统。DouZero是为斗地主设计的AI系统,在Botzone排行榜上的344个AI代理中排名第一。

第一人称射击游戏AI如第5节所示。CTF是典型的三维多人第一人称视频游戏,两支敌对队伍在室内或室外地图上相互对抗。CTF的设定与目前的多人视频游戏有很大不同。更具体地说,CTF 中的智能体无法访问其他玩家的状态,团队中的智能体无法相互通信,这使得该环境成为学习智能体进行通信并适应零样本生成的非常好的测试平台。零样本意味着合作或对抗的智能体不是经过训练的智能体,可以是人类玩家,也可以是任意的人工智能智能体。仅仅基于像人类一样的像素和游戏点作为输入,学习代理 FTW 就达到了强大的人类水平的性能。

第 6 节是关于 RTS 游戏的。RTS游戏作为典型的电子游戏类型,万人对战,自然成为人机游戏的试验场。此外,RTS游戏通常具有复杂的环境,比以往的游戏更多地捕捉到现实世界的本质,使得此类游戏的突破更加适用。DeepMind 开发的 AlphaStar 使用通用学习算法,在《星际争霸》所有三场比赛中都达到了特级大师级别,也超过了活跃在欧洲服务器上的 99.8% 的人类玩家。Commander 作为轻量级计算版本,遵循与 AlphaStar 相同的学习架构,其计算量少了一个数量级,并在现场赛事中击败了两位大师选手。OpenAI Five旨在解决Dota2游戏,这是第一个在电子竞技游戏中击败世界冠军的AI系统。作为一款与Dota2相对相似的电子竞技游戏,《王者荣耀》面临着最相似的挑战,而《决武》成为第一个可以玩完整RTS游戏而不是限制英雄池的AI系统。

在第 7 节中,研究人员总结并比较了所使用的不同技术。基于目前人机游戏人工智能的突破,目前使用的技术可以大致分为两类,即带有自对弈(SP)的树搜索(TS)和带有自对弈或分布式深度强化学习(DDRL)。人口游戏(PP)。需要注意的是,研究人员只是提到了每个类别中的基本或关键技术,在此基础上,不同的人工智能通常会根据游戏引入其他关键模块,而这些新模块有时在游戏中并不通用。树搜索有两种代表性算法:MCTS(通常用于完美信息博弈)和CFR(通常为不完美信息博弈设计)。对于population-play,它用于三种情况:由于游戏特性,不同的玩家/代理不共享相同的策略网络;可以维持种群以克服非传递性等博弈论挑战;群体与基于群体的训练相结合来学习可扩展的智能体。通过比较,研究者讨论了以下两点:如何达到纳什均衡,以及如何成为通用技术。

在第8节中,研究人员展示了当前游戏AI面临的挑战,这可能是该领域未来的研究方向。尽管人机游戏已经取得了巨大进步,但当前技术至少存在以下三个限制之一。首先,大多数AI都是针对特定的人机游戏或特定游戏的地图而设计的,学习到的AI甚至无法用于游戏的不同地图。此外,还没有进行足够的实验来验证人工智能在游戏中受到干扰时的能力。其次,训练上述人工智能需要大量的计算资源。由于巨大的硬件资源门槛,只有有限的组织有能力训练高水平的人工智能,这将阻碍大多数科学研究对该问题的深入研究。第三,大多数AI都是根据其对有限的职业人类玩家的获胜能力来评估的,声称达到专家水平可能有点夸张。本部分介绍了上述限制所面临的潜在方向和挑战。

本文总结并比较了当前人工智能在人机游戏领域的突破技术。通过这项调查,研究人员希望初学者能够快速熟悉这个令人兴奋的领域的技术、挑战和机遇,并能启发研究人员进行更深入的研究。

标签:

免责声明:本文由用户上传,如有侵权请联系删除!